26-01-2024 08:59:29

Un malheureux constat mais …

Comme toutes les entreprises croulent sous les documents, toutes les entreprises croulent sous les données. C'est un véritable océan de données sur lesquelles elles naviguent mais peu d'entre elles peuvent y plonger leur tasse pour étancher leur soif d'informations. Toutes ces données sont comme l'eau de l'océan : pas potable.

Tout le monde y va de sa petite extraction personnelle : on extrait des

données de quelques systèmes satellites et on met ça en Excel, des feuilles

qu'on dissémine tant et plus — l'email est une catastrophe de cet unique

point de vue — et qui seront, pour ceux qui les reçoivent, de nouvelles

sources de … données. On passe un temps infini à élaborer des formules

toutes plus intelligentes les unes que les autres; on génère quelques

graphiques dont on tire des conclusions; on agrège ensuite tout cela dans

des kilomètres de PowerPoint. Vous trouverez ce pattern dans tous les

départements : la comptabilité, le suivi budgétaire, les ressources

humaines, le marketing, les ventes, la logistique, l'informatique, …

CE N'EST PAS UNE CRITIQUE ! C'EST UN CONSTAT ! C'est le vécu de 99%

des entreprises. Cela m'a amené à dire et à écrire The «Excel»

company is a bad company

, une forme de jeu de mots caustique.

Entendons-nous. Il ne s'agit pas de faire le procès d'Excel; il ne s'agit pas non plus de faire le procès de ceux qui utilisent Excel. Il s'agit plutôt de prendre conscience que tout cela génère des problèmes, parfois plus de problèmes que cela n'apporte de solutions. Il s'agit de prendre conscience d'un besoin généralisé : avoir accès aux données, pouvoir les traiter, en extraire de l'information et se servir de cette information dans les processus décisionnels. Amen !

… folle boufée d'espoir

Il s'agit donc de prendre conscience du besoin fondamental et partagé par tous les organes de l'entreprise de disposer de données pour pouvoir prendre de meilleures décisions. Ceux qui utilisent Excel n'ont souvent pas d'autres moyens. Ils sont obligés de vivre de petits arrangements de gauche et droite pour qu'on leur permette d'accéder les données dont ils ont besoin. Comme il s'agit d'accords cachés, souvent obtenus au détour d'une conversation autour de la machine à café, on ne les tient que rarement informés des modifications de la structure des données. Cela casse leurs outils, ou invalide certains calculs. On tire des conclusions erronées. Ces personnes ne sont pas responsables : elles sont victimes. Je plaide donc en faveur d'une aide systémique — j'insiste sur le mot et sa définition, qui est constituant d'un système — pour les soutenir dans leurs démarches. Cela passe par la mise en place généralisée de la Business Intelligence qui n'est rien d'autre que de s'organiser afin de pouvoir se servir des données passées pour prendre des décisions informées concernant le futur. Et c'est là qu'il y a un formidable espoir car tout le monde y vient !

Introduction

L'Intelligence Économique, ou Business Intelligence, concerne le business d'abord et la technologie ensuite. C'est une combinaison et c'est aussi un processus. S'il ne s'ancre pas de manière systémique, il est voué à l'échec. L'intelligence Économique doit imprégner toutes les décisions pour les ancrer dans les données [1] . C'est une démarche scientifique qui permet de fonder les décisions sur des preuves, ce qui en soi une nécessité mais pas une garantie quand on en vient à juger du succès des conclusions présentées.

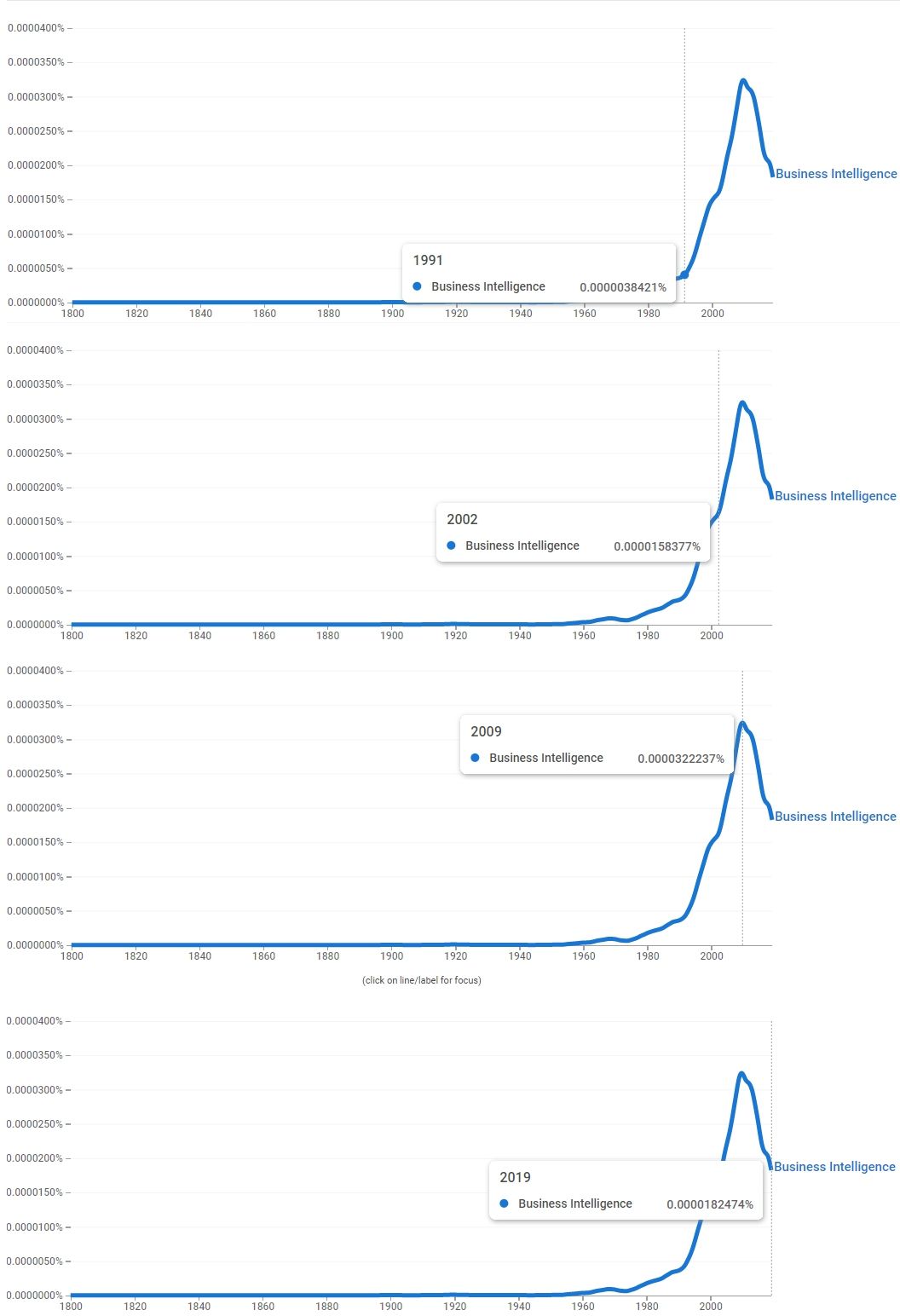

Dès juin 2016, en pleine période professionnelle de Business Intelligence pour un grand acteur du secteur énergétique, je me suis fendu d'un billet appuyé sur le sujet. Mes réflexions ne sont donc pas neuves et on prétendra qu'elles sont même tardives si l'on considère que le démarrage de la notion d''Intelligence Économique est finalement assez ancien (on situe son décollage, assez lent, au début des années 1990 : voir les graphiques ci-dessous).

J'ai pleinement adhéré au principe selon lequel nous devons nous concentrer de plus en plus sur l'Intelligence Économique qui continuera à être un moteur d'expansion informatique pour les 10 prochaines années d'autant que, comme il est dit, les logiciels mangent le monde (Software eats the world)…

Les graphiques présentés ci-dessous montrent à suffisance cette importance grandissante linéaire entre 1992 et 2009.

Depuis 2009, et malgré une sorte de déclin inexorable (2009- 2010), l'intelligence économique est au centre des intérêts des entreprises et de certains intervenants charismatiques. De plus en plus de personnes et d'organisations ont compris que les données, lorsqu'elles sont correctement analysées, contiennent des informations extrêmement précieuses susceptibles d'être la base scientifique de processus décisionnels. Cela a poussé les entreprises et les organismes gouvernementaux à (1) préparer et à consommer les données, (2) à les exposer et à les partager, et (3) à en recueillir et en acquérir de nouvelles, de plus en plus et de plus en plus rapidement. Cependant, depuis le sommet de 2010, l'intérêt semble régulièrement décliner comme je le disais ci-dessus, ce qui se confirme d'ailleurs par les graphiques, du moins lorsqu'on suit les termes de Business Intelligence qui semblent avoir été remplacés par Big Data, Deep Learning, Predictive Analysis, etc. pour lesquels l'intérêt est de plus en plus marqué. Il est singulier de constater qu'au moment où décline le sujet Business Intelligence celui de Data Lake explose.

Attributs

Pour que la Business Intelligence produise des informations appropriées il faut que les données collectées soient précises et correctes. Comme le dit l'acronyme, GIGO… Garbage In, Garbage Out, cette question de qualité des données est essentielle. Elle nécessite le soutien des responsables de domaines Business (LOB — Line Of Business Managers). Si ceux-ci ne sont pas convaincus de la justesse des données, la cellule BI aura du mal à présenter ses rapports comme objectifs.

Il faut également que les informations produites au départ des données aient une quelconque valeur, une utilité. Les données, et donc les conclusions, n'ont aucune valeur si elles ne sont pas relevantes, par exemple quant à leur ancienneté ou par rapport à leurs circonstances de lieu. Les chiffres des ventes de l'année 1990 ne permettent pas de prendre des décisions informées pour 2020. Les données américaines ne sont d'aucune ou de peu d'utilité pour l'Europe. Collecter les données ne peut se départir de ces circonstances sauf à en sacrifier l'utilité (ce qui n'est pas non plus sans convoquer le concept de metadata, données à propos des données).

Enfin, il est nécessaire que les données et les informations

présentées puissent donner lieu à des conclusions qui devront mener Ã

des actions concrètes. Il en va des données de la

Business Intelligence comme des métriques :

mener à des actions, des actions qui ont un véritable impact, exactement

comme ce qu'est l'innovation : Quelque chose de différent

qui a de l'impact — Something different that has

impact. — Scott D. Anthony

En résumé, les données doivent être irréprochables et les conclusions utiles afin de pouvoir donner lieu à des actions concrètes. Si ce n'est pas le cas, on rate la cible. Sans cette trilogie fiabilité — utilité — actionabiltié, ce que la Business Intelligence est amenée à produire risque d'être nuisible ce qui est pire que si rien n'avait été entrepris.

Une myriade de sources

Lorsqu'il s'agit de consommation de données, les entreprises peuvent se tourner vers une myriade de sources, internes ou externes, publiques ou privées, gratuites ou payantes.

Sources internes

Tous les systèmes opérationnels internes sont susceptibles d'être la source de données précieuses : la comptabilité, le système CRM, l'ERP, les extraits bancaires, les logs de monitoring, …

Le défi est de pouvoir créer ce paysage de systèmes opérationnels qui, malheureusement, n'existe souvent pas. C'est un processus qui peut être long et qui implique de mettre l'entreprise au contact de l'ensemble de ses organes internes, étape préalable essentielle à la mise en place de la colonne vertébrale dont je parle abondamment dans les Transformations Digitales.

Une fois que le paysage est établi, il faut dresser une autre cartographie : celle des données dont on dispose. C'est peut-être bien l'étape la plus difficile car elle se heurte à des évolutions techniques historiques disparates. Que signifie un client dans le système CRM ? Et dans la comptabilité ? Et dans le système des commandes ? Le prix, tel qu'indiqué dans le système A est-il avec TVA ou sans TVA ? Avec remise ou sans remise ? Et qu'en est-il dans le système B ? Comment est formatée une adresse dans tous les systèmes dont on dispose ? Que faire lorsque l'adresse d'un client est différente de système à système ? L'identifiant unique d'un client répond à une forme de standardisation dans le système A mais pas dans le système B; comment fait-on la jonction ? Comment savoir quelle est la donnée la plus à jour ? Tous ceux qui se frottent à la réalité des données comprennent précisément les difficultés que cela évoque et elles sont inombrables. Pour en venir à bout, il faut de très nombreuses discussions avec des équipes dont l'agenda ne permet peut-être pas d'accorder au sujet l'importance du moment souhaitable. C'est compliqué.

Une fois la cartographie des données, il sera nécessaire d'élaborer une stratégie de stockage et traitement des données. On parlera de Data Warehousing ou de Data Lake, on parlera de treaitements en temps réel ou différés. C'est typiquement durant cette phase qu'on établit une architecture des données; c'est également à ce moment où la gouvernance des données est mise en place, où l'on fait le pont avec la sécurité et le respect des données à caractère privé.

Commencer à relier les sources internes de données n'est pas envisageable en mode Waterfall : on analyse tout d'abord et on passe ensuite à l'implémentation une fois que tout est clair et établi. Vous prendriez des années avant de pouvoir générer les premières informations dont pourront se saisir les départements qui en ont besoin. Il faut accepter une progression en mode bit by bit, système après système. Il faut accepter l'idée de prendre des décisions architecturales et/ou techniques qui pourraient être invalidées ultérieurement. Il faut accepter l'idée de devoir refaire certaines parties, illustration parfaite du deuxième système.

Ce site est en construction. Il évolue tous les jours. Voici une de ces pages qui est au menu du travail à mener!

Sources externes

Comme je l'indiquais, l'entreprise peut aussi se tourner avec profit vers des sources externes pour compléter ses propres données. On appelle cela le paradigme Open Data.

Ce mouvement d'Open Data a véritablement démarré en 2006-2008 mais il accélère régulièrement sans fléchir depuis ce qui fait de la situation du mois dernier une image obsolète : elle exige une vision globale, constante et permanente. Un sorte de veille technologique est nécessaire.

Les données sont accessibles gratuitement ou avec abonnement payant. Par exemple, en Belgique, la Banque Carrefour fournit des données de base sur toutes les entreprises et organisations qui disposent d'un compte TVA (adresse, téléphone numéro, administrateur, codes NACE, …). Ce type d'information est fortement utilisé dans Quitus/TRQL par exemple, un Enterprise Suite auquel j'ai participé, basé sur la collection «Je Gère…» (1989-2002), ciblé pour les petites et très petites entreprises, ainsi que pour les indépendants. La France a annoncé le même type d'initiative déjà en 2017, ce qui menace la situation monopolistique de Sirene par exemple. Le monde change ! Non ! C'est un changement de monde !

Enfin, et ce n'est pas le moins important, tout le monde est désireux de recueillir de nouvelles données, de plus en plus, sur tout et n'importe quoi. Bon ou mauvais, faux ou juste, ce n'est pas la question. C'est une réalité ! Là aussi, il y a accélération.

Ces 3 vecteurs — consommer, exposer/partager et rassembler, et peut-être pas dans cet ordre précis — sont tous les trois soumis aux nouvelles technologies, au logiciel et au matériel, qui viennnent et rendent tout cela possible : les puces hyper-puissantes, des serveurs musclés et omniprésents, des capacités de réseau grandissantes, des appareils mobiles de plus en plus connectés (hommes et objets), des satellites, des transmissions prépondérantes, une augmentation de la capacité de stockage, etc. Les entreprises qui veulent tirer parti du nouveau paradigme doivent s'en remettre à la Business Intelligence et, pour ce faire, doivent se tenir au courant d'une douzaine de nouvelles technologies pour laisser effectivement cracher des informations précieuses au départ des données brutes (la transformation des données en informations est au cÅ“ur de la intelligence économique ). Elle doit le faire pour comparer les données, extraire des informations et les représenter mieux que par le passé, rapidement mais pas nécessairement en temps réel. Il y a là une part d'interprétaion, ce qui n'est pas négligeable. L'accent est donc mis sur l'extraction, la signification, et la représentation et les technologies qui permettent justement cela, parfois en remettant en question ce que nous pensions être des connaissances stables.

La transformation des données en informations est au cœur de l'intelligence économique. Cela implique un effort d'interprétation, de représentation et de communication.

Pour pouvoir prendre ce train, les organisations devront combler l'écart entre les entreprises et les technologies de l'information, en remettant souvent en question le sens profond de ce que leur Business est. À mon avis, de nombreuses entreprises n'ont pas bien compris qu'elles sont devenues des entreprises IT, partiellement ou en totalité. Telle est le cas du secteur des assurances et des banques qui tremblent sur leur propre base depuis un certain temps déjà ! Mais que penser de ces secteurs économiques, sérieusement touchés par la crise de la Covid-19 et qui n'ont pu que très difficilement s'adapter à l'introduction du télétravail de masse. Bien entendu, cela va bien au-delà de la simple intelligence économique, mais si nous y réfléchissons avec un peu de recul, il n'est plus possible de se lancer dans une transformation numérique et de négliger la BI — Business Intelligence. Ce serait déraisonnable. Ce serait au-delà de tout … intelligence.

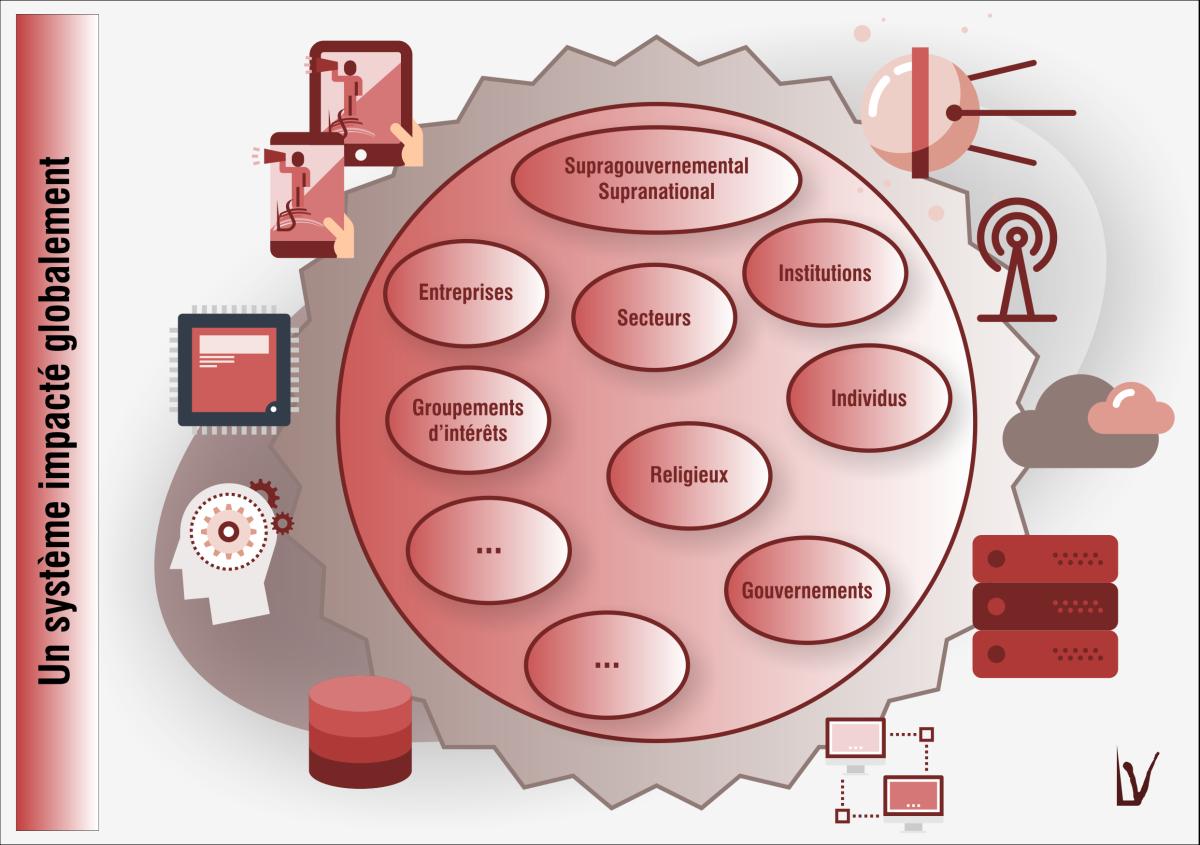

Combler le fossé entre l'IT et le Business, en rapport avec la Business Intelligence, nécessite de construire une chaîne de valeur des données ou "continuum de données" qui sera capable d'examiner les contextes externes et internes. L'analyse des données peut porter de manière égale sur le marché, sur les clients, sur les concurrents, les employés, les processus, les partenaires, les fournisseurs, les autorités, etc. J'estime que la Business Intelligence investira tous ces domaines ou continuera à les investir, éventuellement en combinant cette quête et des intérêts additionnels.

La collecte de données de plus en plus nombreuses est également un défi en soi. Le cloud est LA solution, même si les capacités de stockage ont été multipliées par dix depuis le milieu des années 2000 et que ceci est une réalité pour tout le monde. Mais l'adoption du Cloud n'a pas encore été un mouvement généralisé dans la plupart des organisations, à l'exception de quelques expériences menées en laboratoire [5] . Même avec cette vision plutôt pessimiste, Lato Sensu pense que de plus en plus d'entreprises vont adopter le contexte du cloud pour découvrir qu'il est devenu un lieu très sécurisé [2] et très évolutif, un lieu qui offre des tonnes d'outils intelligents pour travailler sur les données : les fournisseurs de cloud proposent un tas de solutions très intelligentes, allant des utilitaires statistiques à l'intelligence artificielle, en passant par l'apprentissage machine, le Data Crunching, etc. Une vue rapide des services de Microsoft, ou des API de Google, ou des services d'Amazon vous donne une idée de ce qui est possible aujourd'hui avec un investissement (très) limité. Ces services, qui sont offerts presque gratuitement [3], proposent des possibilités inégalées telles que l'apprentissage automatique et l'analyse intelligente avec des modèles très sophistiqués. Mais Lato Sensu Management investit également son temps dans son propre ensemble de solutions, parfois très basiques (comme les réseaux Baeysian naïfs) mais aussi extrêmement efficaces pour faire leur travail facilement.

To be continued

Et tout cela, sans même prendre une grande respiration pour examiner ce que l'IdO a à offrir : des capteurs intelligents, une communication en temps réel, un échange de données entre des machines qui consommeront et exposeront des données à leur seule discrétion. La liste des possibilités est illimitée : chaudières intelligentes, compteurs de gaz intelligents, compteurs d'électricité intelligents, ...

Les années à venir sont définitivement celles de l'intelligence économique et des chaînes de valeur des données, quel que soit leur contenant, Transformation numérique ou non. C'est ce que nous croyons.

Business Intelligence et Innovation

Il n'y a pas d'innovation sans Intelligence Économique !

Quelle que soit la méthode choisie pour soutenir l'innovation, vous allez travailler sur des données réelles que vous allez devoir mettre en perspective afin d'imaginer et implémenter des solutions possibles. Cela passe immanquablement par la compréhension (1) du contexte et (2) du client/utilisateur, toutes données que vous serez amenés à extraire de Data marts, de bases de données en temps réel, etc. tous sujets qui croisent la Business Intelligence.

Ceci fait d'ailleurs de l'innovation un organe essentiel, imbriqué dans chaque chaîne de valeur, pour lequel il faudra permettre un accès flexible à l'information stockée. Ce n'est pas le moindre des défis, surtout en matière d'architecture. Il faut prévoir nombre de bacs à sable afin que chaque cellule d'innovation puisse jouer avec les données comme il convient à sa mission sans perturber la mission d'une autre cellule. On commencera alors à évoquer la nécessité de disposer d'environnements éphémères qui sont provisionnés au moment où on en a le besoin et qui disparaissent dès le besoin évanoui.

Ce lien fort entre Business Intelligence et innovation passe aussi par l'établissement de postes d'observation, baptisés postes de vigie ou nids-de-pie.

Quelques sujets touchent dèjà à l'infrastructure, une colonne architecturale simplifiée :

VID - Vigie - Colonne Digitale - Data.jpg)

VID - Vigie - Colonne Digitale - Services - Data.jpg)

To be continued

Notes de bas de page

[1] … Confront the Brutal Facts est un concept, ainsi que son concept compagnon The Stockdale Paradox, développé dans le livre Good to Great de Jim Collins. Le changement productif commence lorsque vous vous confrontez aux faits brutaux. Toute entreprise qui souhaite faire le voyage de Good vers Great a adopté ce que nous avons appelé «Le paradoxe Stockdale» : vous devez maintenir une foi inébranlable dans le fait que vous pouvez et allez finir par l'emporter, quelles que soient les difficultés, et en même temps, avoir la discipline nécessaire pour affronter les faits les plus brutaux de votre réalité actuelle, quels qu'ils soient. — Jim Collins sur Confront The Brutal Facts

[2] … Turning data into information is at the core of Business Intelligence

[3] … It is also important not to be naive; it is up to you to know what data you want to migrate to the Cloud!

[4] … Many mid-size companies can use these services without ever exceeding the quotas offered through free subscriptions.

[5] … L'adoption du Cloud dans les services publics reste très prudente; pareil dans le monde des assurances ou des banques